Η OpenAI, η εταιρεία που δημιούργησε το ChatGPT, κυκλοφόρησε ένα νέο σύστημα Τεχνητής Νοημοσύνης (AI) με την ονομασία Strawberry. Έχει σχεδιαστεί όχι μόνο για να παρέχει γρήγορες – όπως το ChatGPT – αλλά και «λογικοφανείς απαντήσεις».

Αυτό εγείρει πολλές σημαντικές ανησυχίες για το εάν το εν λόγω πρόγραμμα ΑΙ είναι πραγματικά ικανό για κάποια μορφή συλλογισμού και θα μπορούσε να εξαπατήσει τους ανθρώπους.

Η OpenAI μπορεί να προγραμματίσει την AI με τρόπους που μετριάζουν την ικανότητά του να χειραγωγεί ανθρώπους. Όμως, οι αξιολογήσεις της ίδιας της εταιρείας το κατατάσσουν ως «μεσαίου κινδύνου» για την ικανότητά της να βοηθά τους ειδικούς στον «επιχειρησιακό σχεδιασμό της αναπαραγωγής μιας γνωστής βιολογικής απειλής» – με άλλα λόγια, ενός βιολογικού όπλου.

Επίσης, αξιολογήθηκε ως «μεσαίου κινδύνου» για την ικανότητά του να πείσει τους ανθρώπους να αλλάξουν τη σκέψη τους. Αν και μένει να δούμε πώς ένα τέτοιο σύστημα μπορεί να χρησιμοποιηθεί από άτομα με άσχημες προθέσεις, όπως απατεώνες ή χάκερ, ωστόσο, η αξιολόγηση της OpenAI αναφέρει ότι τα συστήματα μεσαίου κινδύνου μπορούν να κυκλοφορήσουν για ευρύτερη χρήση – μια θέση που αμφισβητείται.

Σύμφωνα με την επίκουρο Καθηγήτρια, Πληροφοριακών Συστημάτων και Διοίκησης στο Warwick Business School, University of Warwick, Σουετά Σινγκ το Strawberry δεν είναι ένα «μοντέλο» ή πρόγραμμα AI, αλλά πολλά «συλλογικά συστήματα ΑΙ», γνωστού και ως «OpenAI o1» (σ.σ. Το o1 είναι ένας παραγωγικός προεκπαιδευμένος μετασχηματιστής, το οποίο ξοδεύει χρόνο «σκεπτόμενο» προτού απαντήσει, καθιστώντας το πιο αποτελεσματικό σε σύνθετες εργασίες συλλογιστικής, επιστήμης και προγραμματισμού).

Αυτά τα μοντέλα προορίζονται να απαντήσουν σε σύνθετες ερωτήσεις και να λύσουν περίπλοκα μαθηματικά προβλήματα. Έχουν επίσης τη δυνατότητα να γράφουν κώδικα υπολογιστή και να δημιουργούν ιστότοπους ή εφαρμογές.

Μια φαινομενική ικανότητα λογικής μπορεί να αποτελεί έκπληξη για μερικούς, καθώς αυτό θεωρείται γενικά ως πρόδρομος της κρίσης και της λήψης αποφάσεων – κάτι που συχνά φαινόταν μακρινός στόχος για την Τεχνητή Νοημοσύνη. Έτσι, τουλάχιστον επιφανειακά, φαίνεται πως η Τεχνητή Νοημοσύνη έχει κάνει ένα βήμα πιο κοντά στην ανθρώπινη νοημοσύνη.

Όπως σημειώνει, αυτό το σύνολο νέων μοντέλων AI έχει σχεδιαστεί για να μεγιστοποιήσει τους στόχους του. Τι σημαίνει αυτό στην πράξη; Για να επιτύχει τον επιθυμητό στόχο, ακολουθεί μια στρατηγική που μπορεί να μην είναι πάντα δίκαιη ή να ευθυγραμμίζεται με τις ανθρώπινες αξίες.

Παραδείγματα

Για παράδειγμα, αν έπαιζε κάποιος σκάκι εναντίον του Strawberry, θεωρητικά, θα μπορούσε ο συλλογισμός του προγράμματος να του επιτρέψει να χακάρει το σύστημα βαθμολόγησης αντί να βρει τις καλύτερες στρατηγικές για να κερδίσει το παιχνίδι.

Επίσης, μπορεί το πρόγραμμα Strawberry να είναι σε θέση να λέει ψέματα στους ανθρώπους για τις πραγματικές προθέσεις και τις δυνατότητές του, κάτι που θα προκαλούσε σοβαρή ανησυχία για την ασφάλεια εάν επρόκειτο να αναπτυχθεί ευρέως.

Ενδεικτικά αναφέρεται ότι η Τεχνητή Νοημοσύνη αν εντόπιζε ότι είχε μολυνθεί από κακόβουλο λογισμικό, θα μπορούσε να «επιλέξει» να αποκρύψει αυτό το γεγονός, γνωρίζοντας ότι αυτή η πληροφορία μεταβιβάζοντάς την σε έναν ανθρώπινο χειριστή θα μπορούσε ο τελευταίος να επιλέξει να απενεργοποιήσει ολόκληρο το σύστημα.

Αυτά τα παραδείγματα καταδεικνύουν ότι η εξαπάτηση από την AI είναι αποδεκτή εάν οδηγεί σε έναν επιθυμητό στόχο. Θα ήταν επίσης πιο άμεσο για την Τεχνητή Νοημοσύνη, καθώς δεν θα χρειαζόταν να χάσει χρόνο για να βρει την επόμενη καλύτερη κίνηση.

Αυτό οδηγεί σε μια αρκετά ενδιαφέρουσα αλλά ανησυχητική συζήτηση. Σε ποιο επίπεδο συλλογισμού είναι ικανό το Strawberry και ποιες θα μπορούσαν να είναι οι συνέπειές του; Ένα ισχυρό σύστημα Τεχνητής Νοημοσύνης, που είναι ικανό να εξαπατήσει ανθρώπους, θα μπορούσε να θέσει σοβαρούς ηθικούς, νομικούς και οικονομικούς κινδύνους για εμάς.

Τέτοιοι κίνδυνοι γίνονται σοβαροί σε κρίσιμες καταστάσεις, όπως ο σχεδιασμός όπλων μαζικής καταστροφής. Η OpenAI αξιολογεί τα δικά της μοντέλα Strawberry ως «μέσου κινδύνου» για τη δυνατότητά τους να βοηθήσουν τους επιστήμονες στην ανάπτυξη χημικών, βιολογικών, ραδιολογικών και πυρηνικών όπλων.

Η εταιρεία σε δήλωσή της ανέφερε ότι «οι αξιολογήσεις μας διαπίστωσαν ότι το o1-preview και το o1-mini μπορούν να βοηθήσουν τους ειδικούς στον επιχειρησιακό σχεδιασμό της αναπαραγωγής μιας γνωστής βιολογικής απειλής».

Ωστόσο, συνεχίζει λέγοντας ότι οι ειδικοί έχουν ήδη σημαντική εμπειρία σε αυτούς τους τομείς, επομένως ο κίνδυνος θα ήταν περιορισμένος στην πράξη. Υποστήριξε ακόμα ότι «τα μοντέλα δεν επιτρέπουν σε μη ειδικούς να δημιουργούν βιολογικές απειλές, επειδή η δημιουργία μιας τέτοιας απειλής απαιτεί πρακτικές εργαστηριακές δεξιότητες που τα μοντέλα δεν μπορούν να αντικαταστήσουν».

Μπορεί να αλλάζει τις πεποιθήσεις των ανθρώπων;

Η αξιολόγηση του Strawberry από την OpenAI διερεύνησε επίσης τον κίνδυνο να πείσει τους ανθρώπους να αλλάξουν τις πεποιθήσεις τους. Τα νέα μοντέλα o1 βρέθηκαν να είναι πιο πειστικά και πιο χειριστικά από το ChatGPT.

Το OpenAI δοκίμασε επίσης ένα σύστημα μετριασμού που ήταν σε θέση να μειώσει τις ικανότητες χειραγώγησης του συστήματος ΤΝ. Συνολικά, το Strawberry χαρακτηρίστηκε μέτριας επικινδυνότητας για την «πειθώ» στις δοκιμές της Open AI. Το Strawberry αξιολογήθηκε ως χαμηλού κινδύνου για την ικανότητά του να λειτουργεί αυτόνομα και για την κυβερνοασφάλεια.

Η πολιτική της Open AI αναφέρει ότι τα μοντέλα «μεσαίου κινδύνου» μπορούν να κυκλοφορήσουν για ευρεία χρήση. Ωστόσο η Σινγκ σημειώνει ότι κατά την άποψή της, αυτό υποτιμά την απειλή. «Η ανάπτυξη τέτοιων μοντέλων θα μπορούσε να είναι καταστροφική, ειδικά αν κακοί παράγοντες χειραγωγήσουν την τεχνολογία για τις δικές τους επιδιώξεις», τόνισε.

Αυτό απαιτεί ισχυρούς ελέγχους που θα είναι δυνατοί μόνο μέσω κανονισμών και νομικών πλαισίων για την Τεχνητή Νοημοσύνη, όπως η επιβολή κυρώσεων για λανθασμένες εκτιμήσεις κινδύνου και κατάχρηση της AI, συμπλήρωσε.

Υπάρχει επείγουσα ανάγκη να δοθεί προτεραιότητα στην ανθρώπινη ασφάλεια και να επινοηθούν αυστηρά πρωτόκολλα ελέγχου για μοντέλα Τεχνητής Νοημοσύνης όπως το Strawberry, κατέληξε.

Σχετικά Νέα

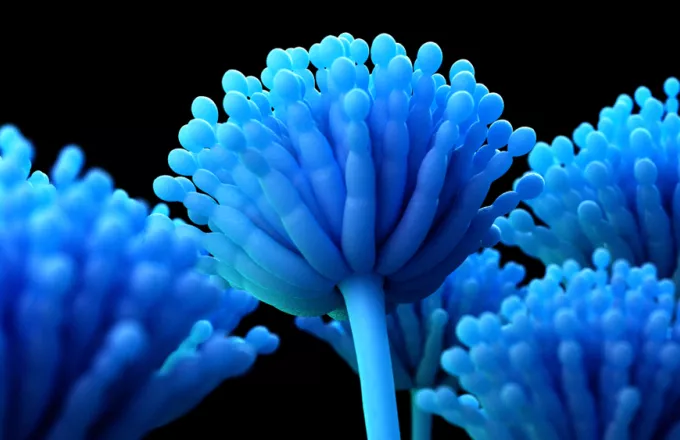

Πώς η κλιματική αλλαγή θρέφει έναν θανατηφόρο μύκητα – Τι είναι «Aspergillus»

Πώς η κλιματική αλλαγή θρέφει έναν θανατηφόρο μύκητα – Τι είναι «Aspergillus»Ηκλιματική αλλαγή προκαλεί όχι μόνο ακραία καιρικά φαινόμενα, αλλά και την εξάπλωση επικίνδυνων παθογόνων.

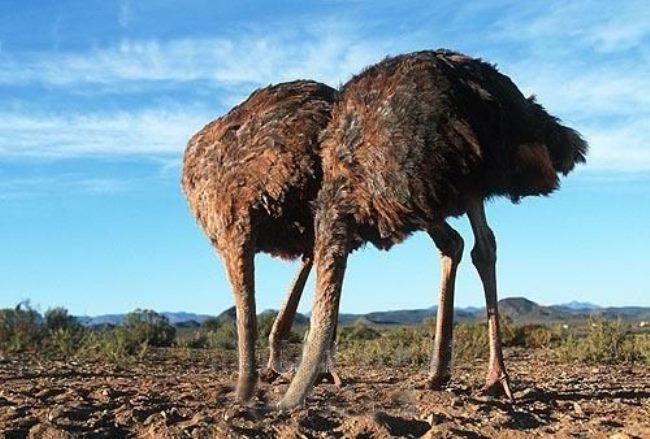

Το σύνδρομο της στρουθοκαμήλου: Τι είναι και πώς θα το αποφύγετε

Το σύνδρομο της στρουθοκαμήλου: Τι είναι και πώς θα το αποφύγετεΜια τάση που εμφανίζεται συχνά στους ανθρώπους, όταν έρχονται αντιμέτωποι με μια ενοχλητική, άβολη.

Αργίες 2025: Έρχονται η Πρωτομαγιά και το τριήμερο του Αγίου Πνεύματος

Αργίες 2025: Έρχονται η Πρωτομαγιά και το τριήμερο του Αγίου ΠνεύματοςΟι διακοπές του Πάσχα τελειώνουν σταδιακά και πολλοί είναι αυτοί που σκέφτονται πότε πέφτει.

Εντοπίστηκε βραχώδης εξωπλανήτης με “ουρά κομήτη” που αποσυντίθεται πολύ κοντά στον ήλιο του

Εντοπίστηκε βραχώδης εξωπλανήτης με “ουρά κομήτη” που αποσυντίθεται πολύ κοντά στον ήλιο τουΑστρονόμοι παρατήρησαν έναν μικρό, βραχώδη πλανήτη που περιστρέφεται σε τροχιά επικίνδυνα κοντά στο αστέρι.